NVIDIA представи най-мощния чип в света Blackwell B200, както и сървърните системи HGX B100, B200 и DGX B200

Вчера, на конференцията GTC 2024 NVIDIA представи ИИ-ускорители от следващо поколение, използващи графични процесори Blackwell.

Те ще позволят създаването на още по-големи невронни мрежи, включително големи езикови модели (LLM) с трилиони параметри и ще бъдат до 25 пъти по-енергийно ефективни и рентабилни от поколението Hopper.

Архитектурата Blackwell е кръстена на американския математик Дейвид Харолд Блекуел и включва редица иновативни технологии за ускоряване на изчисленията. Те ще помогнат за пробив в обработката на данни, инженерното моделиране, автоматизацията на проектирането на електроника, компютърно подпомаганото проектиране на лекарства, квантовите изчисления и генеративния ИИ. NVIDIA поставя специален акцент върху последното:

„Генеративният ИИ е определящата технология на нашето време. Графичните процесори Blackwell са двигателят на новата индустриална революция.“

подчерта главният изпълнителен директор на Nvidia Дженсън Хуанг по време на презентацията

Графичният процесор NVIDIA B200 е най-мощният чип в света.

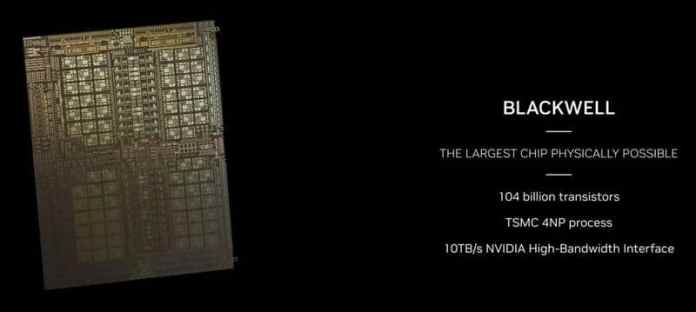

При изчисленията в FP4 и FP8 новият графичен процесор осигурява производителност съответно до 20 и 10 Pflops. Той се състои от два кристала, които са произведени по специална версия на 4 nm 4NP процес на TSMC и са комбинирани с 2,5D CoWoS-L пакет. Това е първият графичен процесор на NVIDIA с чипсетна подредба. Чиповете са свързани с шина NV-HBI с широчина на честотната лента от 10 TB/s и работят като един графичен процесор. Като цяло Blackwell B200 има 208 милиарда транзистора.

Отстрани на кристалите на графичния процесор са разположени 8 стека HBM3e памет с общ капацитет 192 GB. Широчината на честотната лента достига 8 TB/s. За да се комбинират няколко ускорителя Blackwell в една система, новият графичен процесор получи поддръжка на интерфейса NVLink от пето поколение, което осигурява пропускателна способност до 1,8 TB/s в двете посоки. С помощта на този интерфейс (комутатор NVSwitch 7.2T) могат да бъдат обединени до 576 графични процесора.

Един от основните източници на по-високата производителност на B200 са новите тензорни ядра и второто поколение на Transformer Engine.

Последният се е научил по-фино да подбира необходимата точност на изчисленията за определени задачи, което се отразява както на скоростта на обучение и работа на невронните мрежи, така и на максималния обем на поддържаните LLM. Сега NVIDIA предлага обучение на изкуствен интелект във формат FP8, а FP4 ще бъде достатъчен за работа с обучени невронни мрежи. Имайте предвид, че Blackwell поддържа работа с голямо разнообразие от формати. Включително FP4, FP6, FP8, INT8, BF16, FP16, TF32 и FP64.

Водещият ускорител на новата архитектура ще бъде суперчипът NVIDIA Grace Blackwell, който съчетава двойка графични процесори B200 и централния процесор NVIDIA Grace Arm със 72 ядра Neoverse V2.

Този ускорител е с ширина половин сървърен шкаф и има TDP до 2,7 kW. Производителността при операции FP4 достига 40 Pflops, а при операции FP8/FP6/INT8 новият GB200 може да осигури 10 Pflops.

Както отбелязва самата Nvidia, новият продукт осигурява 30-кратно увеличение на производителността в сравнение с Nvidia H100 за работни натоварвания, включващи големи езикови модели и е до 25 пъти по-икономичен и енергийно ефективен.

NVIDIA представи и сървърните системи HGX B100, HGX B200 и DGX B200. Всички те предлагат по 8 ускорителя Blackwell, свързани чрез NVLink 5. Системите HGX B100 и HGX B200 нямат собствен процесор и се различават помежду си само по консумацията на енергия и съответно по мощността. HGX B100 е ограничена до TDP от 700 W и осигурява до 112 и 56 Pflops съответно в FP4 и FP8/FP6/INT8 операции . HGX B200 има TDP от 1000W и предлага до 144 и 72 Pflops съответно в операции FP4 и FP8/FP6/INT8.

И накрая, DGX B200 повтаря HGX B200 по отношение на производителността, но представлява цялостна система с двойка процесори Intel Xeon Emerald Rapids. Според NVIDIA, DGX B200 е до 15 пъти по-бърз в задачата за изпълнение на вече обучени „трилионни“ модели в сравнение с предшественика си.

За най-мащабните системи за изкуствен интелект, включващи от 10 000 до 100 000 ускорителя GB200 в рамките на един център за данни, Nvidia предлага да ги клъстерира.

Много производители скоро ще представят своите системи, базирани на Nvidia B200, включително Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn и ZT Systems. Nvidia GB200 е също така част от платформата Nvidia DGX Cloud. По-късно през тази година решения, базирани на този суперчип ще бъдат достъпни от големите доставчици на облачни услуги, включително AWS, Google Cloud и Oracle Cloud.