AMD и Qualcomm предизвикват Nvidia с революционна SOCAMM памет

Изглежда, че монополът на Nvidia на иновативните решения в областта на оперативната памет за AI-сървърите е към своя край. Според южнокорейски източници, AMD и Qualcomm работят активно за внедряването на стандарта SOCAMM в бъдещите си продукти. Целта е да се елиминира ограниченият капацитет на паметта, който се превърна в пречка при автономните AI-системи.

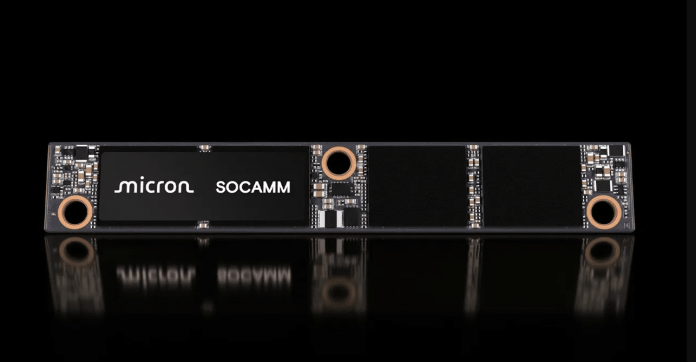

Досега технологията SOCAMM се възприемаше като „тайнотото оръжие“ на Nvidia. Това решение, базирано на енергийно ефективни LPDDR чипове (традиционно използвани в лаптопите и смартфоните), внедрява ключова промяна: модулност. За разлика от постоянно запоената LPDDR5X памет или скъпите HBM стекове, SOCAMM е сменяема и мащабируема, което я прави идеално допълнение към ултрабързата HBM памет за приложенията, изискващи съхранение на масиви от данни.

Според доклад на Hankyung, AMD и Qualcomm не възнамеряват сляпо да копират „зелените“ решения. И двете компании проучват концепцията за специфичен квадратен модул, в който DRAM чиповете са подредени в два реда. Ключовата инженерна разлика се състои в интегрирането на схемата за управление на захранването директно върху самия памет модул.

Този подход има специфични предимства:

– Стабилност при екстремни скорости: Регулирането на напрежението се осъществява точно до чиповете памет, елиминирайки смущенията и позволявайки по-високи тактови честоти.

– Опростяване на конструкцията: преместването на захранващата секция към модула облекчава дънната платка, намалявайки нейната сложност и производствени разходи.

Защо всички изведнъж бързат да възприемат този стандарт? Отговорът се крие в нарастващите изисквания на така наречените ИИ-агентни (тоест, автономен изкуствен интелект). Съвременните езикови модели изискват достъп до милиони контекстни маркери в реално време. HBM паметта, макар и ненадмината по пропускателна способност, е твърде скъпа и има твърде малък капацитет.

SOCAMM се превръща в идеалното кеш-хранилище. То позволява оборудването на един процесор с терабайти оперативна памет, което е достатъчно бързо и енергийно ефективно, за да поддържа готовност за гигантските бази знания на AI-агентите. Тъй като Nvidia планира да внедри SOCAMM 2 в предстоящата си платформа Vera Rubin, този ход на конкурентите сигнализира, че до 2026 г. битката за доминация на AI ще се измести от изчислителната мощност към капацитета и ефективността на памет подсистемата.

Какво мисли изкуственият интелект: Надпреварата за производителност на изкуствения интелект очевидно навлиза в нова фаза, където не само суровата изчислителна мощност, но и архитектурата на паметта се превръщат в ключов фактор. Приемането на модулни стандарти като SOCAMM би могло значително да намали разходите и да увеличи гъвкавостта на ИИ-решенията, като в крайна сметка ускори тяхното разпространение.

Спомнете си, че AMD далеч изпреварва Intel, тъй като се появиха бенчмарковете на новия крал на гейм процесорите.